Apple представила ИИ-модель для считывания контекста с экрана

Просмотров: 0

Биржи на которых я торгую:

Исследователи Apple разработали новую ИИ-систему, способную понимать контекст.

Согласно опубликованным документам, функция позволяет более естественно взаимодействовать с голосовыми помощниками.

Система получила название Reference Resolution As Language Modeling (ReALM) — «разрешение ссылок как моделирование языков». Она использует LLM для решения проблемы распознавания ссылок. Это позволяет ReALM добиться значительного прироста производительности по сравнению с существующими методами.

«Способность понимать контекст, включая ссылки, очень важна для разговорного ассистента. Важнейшим шагом в обеспечении подлинной свободы рук при использовании голосовых помощников является возможность задавать вопросы о том, что отображается на экране», — сообщила команда исследователей Apple.

Для работы с экранными ссылками ReALM использует реконструкцию дисплея с помощью синтаксического анализа объектов на нем и их местоположения для создания текстового представления, передающего визуальную схему.

ИИ-модель разработана специально для улучшения возможностей Siri путем учета данных на дисплее и текущих задач. Она категоризирует информацию на три сущности: экранную, разговорную и фоновую.

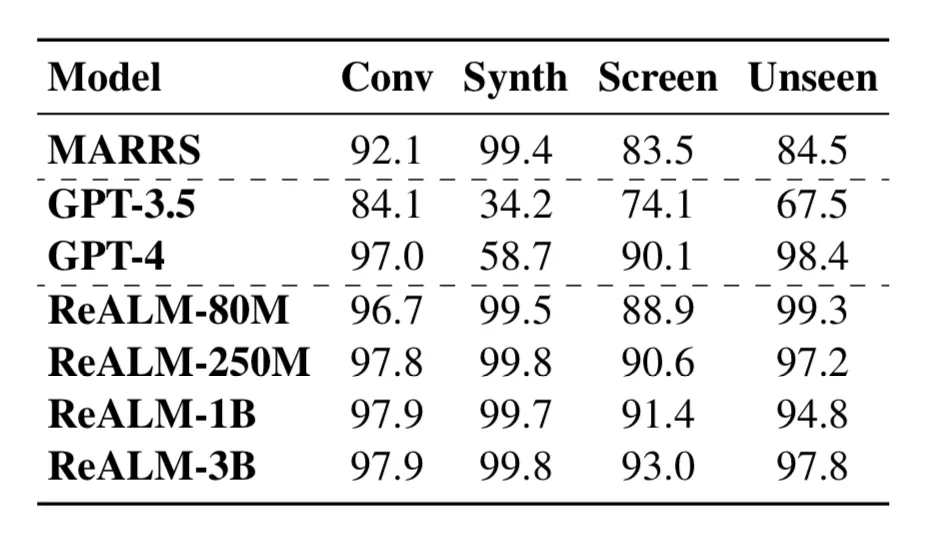

Согласно исследовательской работе Apple, ИИ-система не уступает по своим возможностям GPT-4. Производительность самой маленькой модели ReALM от Apple сравнима с чат-ботом от OpenAI, а более крупные существенно превосходят его.

Напомним, в феврале CEO Apple Тим Кук раскрыл планы корпорации по использованию генеративного ИИ.